3과목 빅데이터 모델링 키워드 정리

제1장 분석모형 설계

분석모형 선정

- 통계 분석 : 객관적인 근거에 기반을 두고 데이터 수집, 처리, 분류, 분석하여 의사결정 지원, 모집단에서 표본을 추출하고 추론 및 가설 검정 실시

- 데이터 마이닝 : 수학이나 통계적 기술을 활용하여 데이터 분석, 새로운 상관관계나 추세를 파악하고 예측 및 분류 등에 활용

- 데이터 유형, 변수, 속성을 파악하고 연구 목적에 맞게 데이터 분석모형 선정

빅데이터 분석 프로세스의 핵심 업무

적합한 분석모형 선정, 분석모형 적용, 성능 및 적합성 평가, 안정성 평가

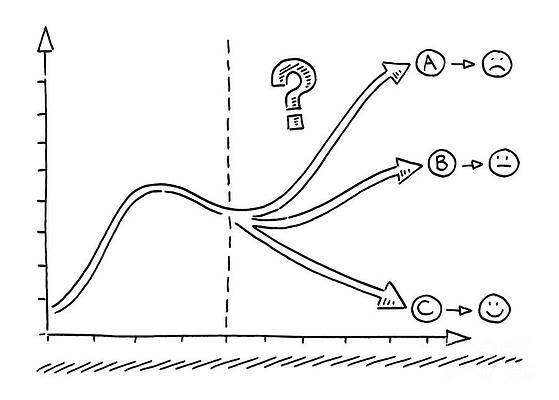

빅데이터 분석 방법(분석대상과 분석방법의 유무에 따른 분류)

- 최적화(Optimization) : 목적함수, 제약조건 정의 후 문제해결

- 솔루션(Solution) : 분석 대상은 알면서 분석방법을 모르는 경우 적용

- 통찰(Insights) :분석대상이 명확하지 않은 경우 기본 분석 방식 활용

- 발견(Discovery) : 새로운 분석 대상 도출, 정확도가 중요함

데이터 분석모형 구축 절차

요건정의 -> 모델링 -> 검증 및 테스트 -> 적용 -> 주기적 검토

데이터 분석모형 구축 시 고려사항

데이터 처리, 시각화, 공간분석, 탐색적 자료 분석, 통계 분석, 데이터 마이닝, WBS수립, 결측치 및 이상치 처리 방법

소프트웨어 분석 방법론

- 폭포수 모델 : 체계적이고 순차적인 개발 접근 방법

- 나선형 모델 : 반복을 통한 점증적 개발 방법

- 프로토타입 모델 : 시스템 일부분을 구현한 후 다음 요구사항을 반영, 점진적 개발 방법

빅데이터 처리 시스템

- 대용량 데이터를 분산 병렬 처리하고 관리하는 시스템

- 빅데이터 수집/관리/유통/분석 과정 수행

- 주요 기능 : 데이터 검증, 실시간 배치 처리를 위한 프레임워크 제공, 데이터 품질관리 등

- 구축 절차 : 빅데이터 처리 환경 분석 -> 빅데이터 처리 시스템 세부 계획 수립 -> 기존 시스템 연계 고려 - 빅데이터 처리 환경 구축

빅데이터 저장 시스템

- 관계형 데이터베이스(Relational DBMS) : 주로 정형 데이터 유형의 데이터 저장

- NoSQL : 기존 RDBMS와 비교하여 상대적으로 제한이 덜한 데이터 모델 적용

- 하드웨어 : 마스터 노드(메모리 상에서 처리해야 할 작업이 많은 경우 고용량 메모리 요구)와 슬레이브 노드(팡일블록 저장, 작업 수행 노드)로 구분

- 소프트웨어 : 데이터 수집, 변환, 적재, 데이터 관리 및 분석용 소프트웨어로 구분

데이터 분석 도구

- 하둡(Hadoop) : 대용량의 데이터 분산 처리, 자바 기반의 오픈소스 프레임워크, 아파치 재단 관리

- R : 오픈소스 프로그램, 통계 계산 및 데이터 마이닝, 시각화 지원

- MapReduce : 분산 병렬 컴퓨팅 환경에서 데이터 처리, 맵 함수와 리듀스 함수 기반 데이터 병렬 처리, 구글 개발

- SPSS : 사회과학 자료 분석용으로 고안, 사용의 편리, 보편적으로 많이 사용

- SAS : 통계 전문가들이 주로 사용, 보고서 작성 기능 제공, 그래픽 기능 제공

텍스트 마이닝을 위한 텍스트 수집 도구

- Scraping : 크롤러와 달리 하나의 웹문서(웹사이트)에 대한 정보 수집

- Crawling : SNS, 뉴스, 웹 정보 등 인터넷에서 제공되는 웹문서 정보 수집

- RSS : 웹 기반 최신 정보 공유, XML 기반의 콘텐츠 배급 프로토콜 이용

- Open API : 데이터, 정보, 각종 서비스 등을 어디서나 쉽게 이용할 수 있는 개방형 API로 데이터 수집

데이터 분할

- 데이터 분석 목적에 부합하는 데이터 분석모형과 모형 구축을 위한 데이터의 질이 중요하며, 분석모형의 성능을 개선하기 위하여 데이터를 훈련, 검증 및 평가 검증 데이터 세트로 분할함

- 훈련 데이터 세트 : 가장 큰 데이터세트로 빅데이터 통계 모듈 구축을 위해 사용, 데이터 분서모형 개발을 위한 학습(훈련) 데이터

- 검증 데이터세트 : 모형을 비교하여 좋은 모형을 선택하기 위해 사용, 각 모형의 성과를 평가하기 위해 사용

- 평가 검증 데이터 세트 : 새로운 데이터를 이용하여 선택된 모형의 성능을 평가하기 위한 용도로 사용

- 과적합 : 제한된 훈련 데이터 세트에 너무 과하게 특화되어 새로운 데이터에 대한 오차가 매우 커지는 현상

'데이터분석' 카테고리의 다른 글

| 빅데이터 분석기사 준비 - 3. 빅데이터 모델링 :: 분석기법 적용 (0) | 2022.03.31 |

|---|---|

| 빅데이터 분석기사 준비 - 2. 빅데이터 탐색 :: 통계기법 이해 (0) | 2022.03.26 |

| 빅데이터 분석기사 준비 - 2. 빅데이터 탐색 :: 데이터 탐색 (0) | 2022.03.26 |

| 빅데이터 분석기사 준비 - 2. 빅데이터 탐색 :: 데이터 전처리 (0) | 2022.03.24 |

| 빅데이터 분석기사 준비 - 1. 빅데이터 분석 기획 :: 데이터 수집 및 저장 (0) | 2022.03.23 |